News

L’Intelligence artificielle symbolique contre-attaque

25 février 2019

Lettre 3AF

Vue 138 fois

“N’oublie pas qui tu es !” dit un personnage de cinéma d’animation à son enfant... Aurions nous oublié ce que nous sommes, et ce que nous avons fait ? Au moment ou déferlent des torrents de notes, de dossiers et de documents sur cette Intelligence Artificielle soudainement révolutionnaire ? Le but de ce résumé est de rappeler quelques étapes essentielles qui se sont curieusement effacées de nos mémoires. Que ce soit pour le monde qui semble avoir oublié les messages pourtant si simples et prometteurs des fondateurs de l’IA, pour la France qui a oublié ses génies et ses pionniers, et aussi pour l’ONERA où tant de beaux projets très innovants se sont endormis dans nos fichiers ...

Pour ne pas alourdir la rédaction, deux textes de référence sont seulement proposés, le lecteur ayant aussi bien en librairie que sous forme libre électronique un immense ensemble de publications. Au premier chef : notre collègue Jean-Gabriel Ganascia a commis un remarquable ouvrage [1] dans lequel, avec la finesse et la puissance intellectuelles qui sont sa marque, il met en perspective à la fois l’histoire et les enjeux humains de cette fascinante discipline. Dans un tout autre espace, il faut mentionner le panorama de vulgarisation compilé par Olivier Ezratty [2].

Récemment, un certain nombre de signaux pas si faibles nous avaient pourtant alertés de ce retour de l’IA notamment en 2016 : rapport de l’administration Obama, de Stanford, du gouvernement britannique et en France le Livre blanc de l’INRIA ... L’accélération - Rapport de Cédric Villani, Initiatives des 3IA, .. - était donc prévisible. Mais en réalité, le feu couvait depuis longtemps ; d’ailleurs, comment tout cela a donc commencé ?..

Les principes fondateurs de l’IA naissent dans l’esprit de plusieurs génies dont John Mc Carthy qui, avec Marvin Minsky, rédige et publie le 31 août 1955 l’annonce d’un colloque en petit comité (environ 6 scientifiques) devant se ternir à l’été 1956. Le terme “intelligence artificielle” y apparaît donc pour la toute première fois : We propose that a 2 month, 10 man study of artificial intelligence be carried out during the summer of 1956 at Dartmouth College in Hanover, New Hampshire.

Examinons la phrase, essentielle, fondamentale, de ce texte : The study is to proceed on the basis of the conjecture that every aspect of learning or any other feature of intelligence can in principle be so precisely described that a machine can be made to simulate it.

Il y a donc trois étapes très simples et dont on peut affirmer (en tout cas l’auteur de cet article le revendique) qu’elles n’ont rien perdu de leur remarquable pertinence dans leur définition de l’IA :

1. déterminer une activité ou fonction considérée comme intelligente;

2. la décrire suffisamment précisément;

3. pour faire une machine qui la simule.

Il n’y a absolument rien de changé aujourd’hui... si ce n’est que l’utilisation linguistique très (trop) fréquente du groupe de mots M = “Une intelligence artificielle est capable de ...” occulte l’étape 2. Et nous allons voir qu’elle est pourtant essentielle. L’utilisation textuelle de M suppose en effet que quelque chose d’intelligent est effectué par la machine ou le programme en question : traduire un texte, reconnaître des visages, prédire des comportements ... toutes choses qui, dans l’esprit de la déclaration de 1955, peuvent effectivement être considérées comme intelligentes. Mais ce biais cognitif que nous observons actuellement ne doit pas se soustraire à la critique : tout programme, toute machine effectuant “quelque-chose de compliqué” n’a pas légitimité à être estampillée “ IA ”. Plus simplement : la majeure partie des systèmes désignés par une phrase de type M sont des algorithmes. Des algorithmes et des programmes complexes, sophistiqués et puissants, certes, mais des algorithmes. Or la question clef est : où donc est décrite (étape 2) l’intelligence (étape 1) ?

Donc : à la lumière du programme vivant des pères fondateurs ce sont bien des armées d’algorithmes qui émergent dans nos années 2010, le volet “ représentation des connaissances ” étant occulté et encore en sommeil. Nous verrons en dernière partie qu’il va se réveiller avec force.

Il reste que toutes les questions cruciales avaient été inventoriées notamment par Mc Carthy dont le site internet encore accessible démontre la puissance visionnaire et l’efficience opérative : car si Turing avait décrit une machine virtuelle, Mc Carthy au travers de Lisp, puis du premier système expert majeur (écrit en Lisp) avait quasiment tout dessiné ou esquissé.

Les années 60, 70 et 80 sont incroyablement fécondes en modélisation du traitement hypothético-déductif des connaissances et la logique mathématique est alors la discipline reine. Or la France doit rendre hommage à trois figures essentielles : Jacques Herbrand dont on peut considérer qu’il a dans sa thèse défini la première théorie et méthode de démonstration automatique en logique d’ordre 1 de l’Histoire. Il succombera à un accident de montagne avant d’avoir pu déployer l’étendue de son potentiel scientifique. Dans les années 60, c’est Jacques Pitrat qui décrit le modèle théorique de l’unification, véritable carburant des démonstrateurs automatiques. Puis en 1972, c’est Alain Colmerauer qui définit le premier interpréteur PROLOG (programmation en logique). Les Japonais ne s’y trompent pas : le gouvernement décide un vaste programme d’ordinateurs de cinquième génération dont le ‘chip’ est fondé sur prolog ... puis ce sont côté Etats-Unis les ‘machines LISP’ qui apparaissent, considérées alors comme les Rolls-Royce des laboratoires d’IA. Lisp et Prolog restent au demeurant les seuls langages de programmation qui soient mathématiquement fondés (respectivement lambda-calcul et logique). Mais la force brute et la puissance des ordinateurs “traditionnels” viendront fouler au pied les espoirs d’une efficacité fondée sur l’intelligence simulée.

Et à l’ONERA ?

Sous l’impulsion de Jean Erceau, Docteur d’état en physique, et François-Régis Valette, un Groupement d’Intelligence Artificielle est créé à l’Office et durant ces années 80 et 90 il permettra de mener une vingtaine de projets totalement innovants et d’organiser tout autant de conférences, ateliers et séminaires. La fusion de connaissances, la conception distribuée, la décision répartie, les langages multi-agents, les patrimoines de connaissances, etc., tous les sujets fondamentaux de l’IA et des Sciences Cognitives ont été étudiés et parfois créés à l’ONERA. Les coopérations avec nos partenaires internationaux et nationaux, tant universitaires qu’EPST (Enseignement public à caractère scientifique) est intense. Ayons également une pensée pour notre collègue Rose Dieng, de l’INRIA, première femme du continent africain diplômée de Polytechnique, pionnière du web sémantique avec laquelle maintes recherches ont été conduites. Tant de projets endormis ou oubliés parfois ...

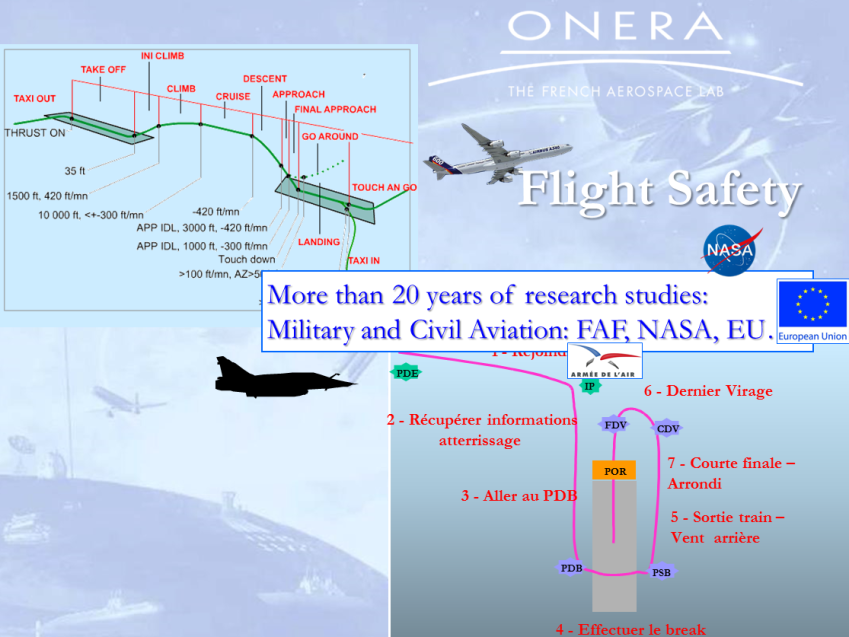

L’Office a ainsi travaillé pendant plus de 20 ans sur tous les aspects liés à la sécurité aéronautique, s’appuyant massivement sur des modèles de l’IA pour concevoir des méthodes et des systèmes d’assistance à la sécurité mis au point dans le domaine civil avec la NASA, la DGAC, l’Union Européenne et des compagnies et dans le domaine militaire avec l’Armée de l’air et l’IRBA (Institut de recherche biomédicale des armées). Des millions de données ont été traitées et méritent d’ailleurs de nouvelles analyses notamment au travers du principe du “positive mining”.

Et maintenant ?

Notre Maître Jacques Pitrat l’a rappelé lors d’une conférence il y a quelques semaines. Le propre de l’homo sapiens sapiens est la méta-cognition : l’application de la connaissance à elle même. Jacques Pitrat avait offert à la communauté les bases mathématiques des méta-règles ; il nous incite à poursuivre cette voie du “bootstrap” de l’IA.

Dans un prochain article nous détaillerons les composantes incontournables et prometteuses de cette nouvelle étape de l’Intelligence Artificielle Symbolique : métacognition, auto-organisation, dynamique des connaissances, causalité, décision répartie, confiance, explicabilité, preuve ...

Note : au fait : nous avons dit “symbolique” ?.. Est symbolique ce “qui n’a de valeur que par ce qu’il exprime ou évoque”. Cela exclut donc les nombres, les calculs, et donc les algorithmes.

Références

- Laurent M. Chaudron and Olivier Bartheye, Computational Contexts, Sense and Action : how a Machine can Decide? To appear: Intl AAAI Conference: Artificial Intelligence (AI), Autonomous Machines and Human Awareness: User Interventions, Stanford, 2019.

- Damien L’Haridon, Laurent Chaudron, Anne-Lise Marchand, Yves Gourinat, Teams Coping with Unknown Failures in Aerospace and Operational Environments, Proceedings the 2018 Europe Chapter of the Human Factors and Ergonomics Society, Berlin, October 8-10 2018.

- Laurent Chaudron, Metacognition and the Continuous World paradigm, Intl. NATO Conference on Artificial Intelligence, Autonomy, Delegation and Responsability, 21 June 2017, Bordeaux, France.

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.